本研究提出了一种创新的基于深度学习的卷积神经网络(CNN)书法风格识别系统。随着书法艺术在传统文化中的重要地位日益突出,如何高效、准确地识别和分类不同风格的书法作品成为了研究者和技术开发者关注的热点问题。为了应对这一挑战,我们设计了一套全面的解决方案,能够自动识别并分类五种不同书法风格:草书、楷书、隶书、行书和篆书。

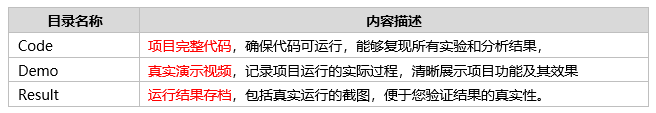

项目信息

编号:PDV-155

大小:1.75G

运行条件

Python开发环境:

– PyCharm的安装包:PyCharm: Python IDE for Professional Developers

– PyCharm的历史安装包:PyCharm: Python IDE for Professional Developers

– Anaconda的安装包:Anaconda | Start Coding Immediately

– Python开发版本:Python==3.9

需要安装依赖包:

– pip install PyQt5== 5.15.11

– pip install Pillow==9.5.0

– pip install opencv-python==4.10.0.84

– pip install torch==2.4.0

– pip install torchvision==0.19.0

– pip install numpy== 1.26.4

– pip install matplotlib==3.9.2

项目介绍

本研究提出了一种创新的基于深度学习的卷积神经网络(CNN)书法风格识别系统。随着书法艺术在传统文化中的重要地位日益突出,如何高效、准确地识别和分类不同风格的书法作品成为了研究者和技术开发者关注的热点问题。为了应对这一挑战,我们设计了一套全面的解决方案,能够自动识别并分类五种不同书法风格:草书、楷书、隶书、行书和篆书。

本系统的核心思想是通过构建一个深度卷积神经网络模型,利用CNN强大的特征提取能力,从书法图像中提取具有辨识度的特征,进而进行准确的风格分类。为了保证系统在复杂书法风格间的区分度,模型采用了多层卷积结构,结合激活函数、池化层及全连接层的优化设计,以更好地捕捉书法作品中的细节特征。

为了进一步增强系统的用户体验,我们结合了PyQt5界面设计,使得系统具备友好的操作界面,用户可以通过简单的交互界面上传书法图像或视频,并实时获得书法风格的识别结果。该界面不仅支持图片输入,还可以通过视频进行连续帧的风格识别,具有较高的实用性。

在数据集的构建方面,我们收集了大量具有代表性的书法作品,并精心标注了每种书法风格。该数据集涵盖了不同风格的书法字形和书写习惯,确保了训练过程中样本的多样性与全面性,进而提升了模型的识别能力。此外,系统还采用了数据增强技术,包括图像旋转、翻转、缩放等手段,以扩展训练样本并增强模型的泛化能力。

在模型训练过程中,我们不断调整网络结构、优化算法,并采用交叉验证和正则化技术来防止过拟合。通过这些技术手段,我们显著提高了模型的训练效果和最终的识别精度。实验结果表明,该系统在五种书法风格的识别任务中均表现出色,准确率达到了较高水平,展示了深度学习模型在书法风格识别中的巨大潜力。

本系统不仅具备较强的实用性,还具有广泛的推广价值。其应用前景涵盖了书法鉴定、文化遗产保护、数字艺术创作等多个领域,能够为书法艺术的传承和创新提供技术支持。我们相信,随着深度学习技术的不断发展和完善,该系统在未来的书法风格识别中将发挥更大的作用。

项目文档

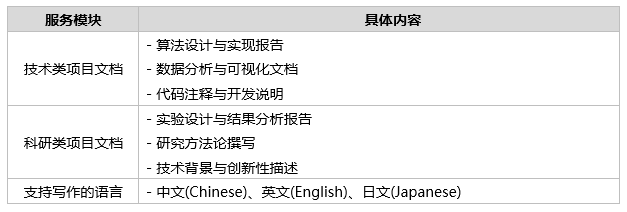

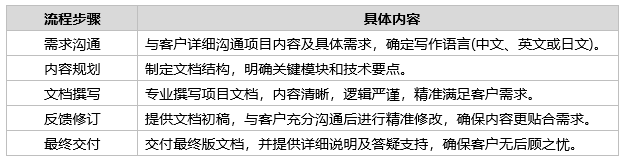

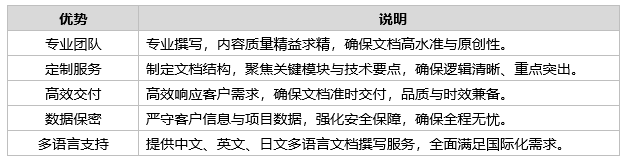

Tipps:提供专业的项目文档撰写服务,覆盖技术类、科研类等多种文档需求。我们致力于帮助客户精准表达项目目标、方法和成果,提升文档的专业性和说服力。

– 点击查看:写作流程

1.撰写内容

2.撰写流程

3.撰写优势

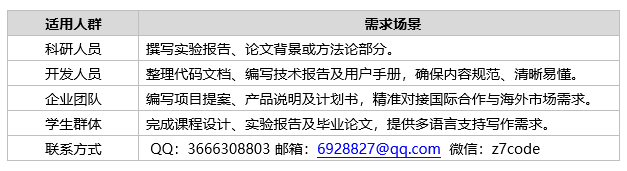

4.适用人群

期待与您的沟通!我们致力于为您提供专业、高效的项目文档撰写服务,无论是通过QQ、邮箱,还是微信,您都能快速找到我们。专业团队随时待命,为您的需求提供最优解决方案。立即联系,开启合作新篇章!

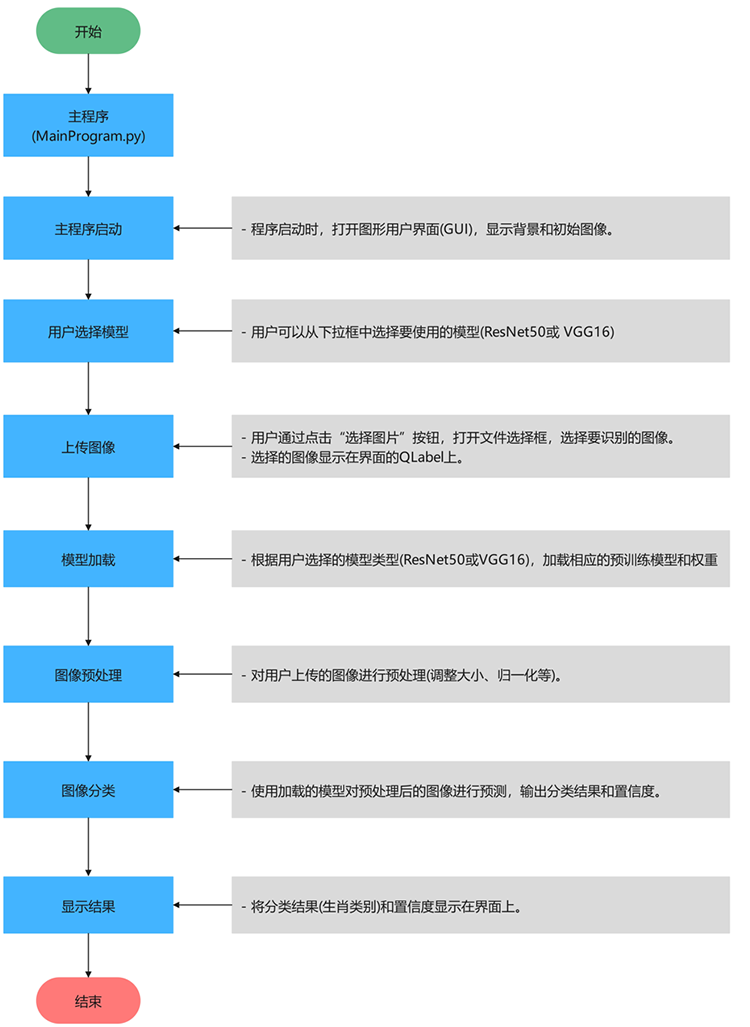

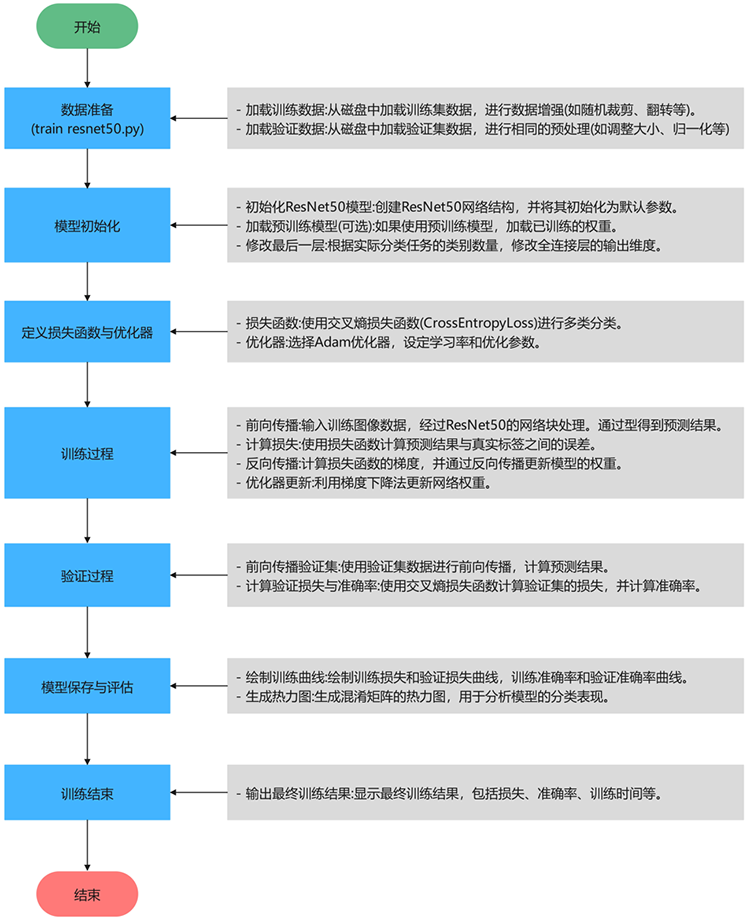

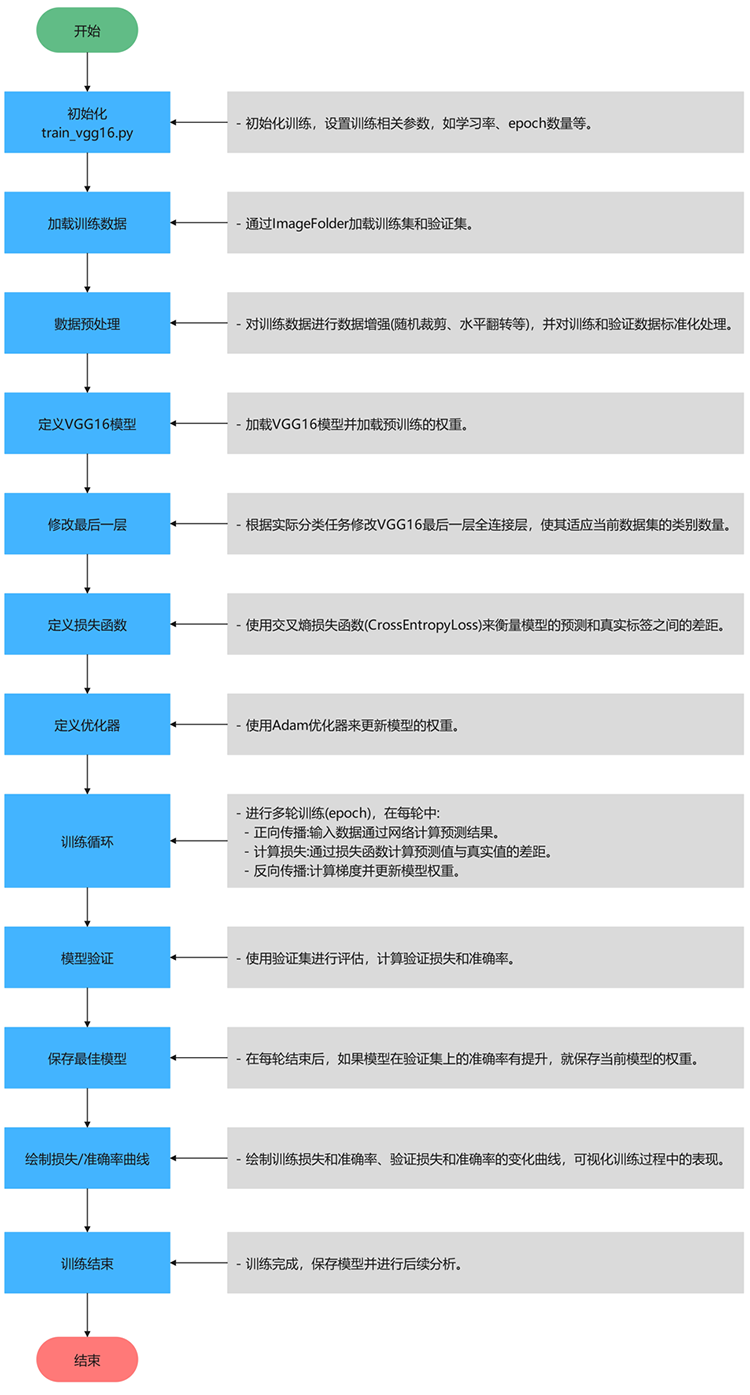

算法流程

Tipps:深入解析项目的算法流程,逐步探索技术实现的核心逻辑。从数据加载与预处理开始,到核心算法的设计与优化,再到结果的可视化呈现,每一步都将以清晰的结构和简洁的语言展现,揭示技术背后的原理与实现思路。

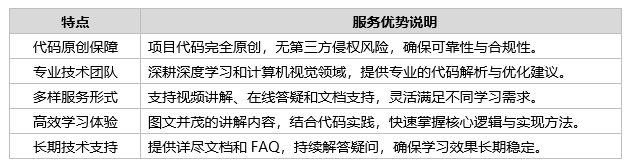

代码讲解

Tipps:我们致力于为您提供全面的项目代码解析服务,深入剖析核心实现、关键逻辑及优化策略,帮助您快速理解项目运行机制。同时,针对您在使用项目中可能遇到的难点,我们提供高效的后续答疑支持,确保问题得到及时、专业的解决。

无论您是初学者还是经验丰富的开发者,我们都能为您量身定制指导方案,助您从掌握到精通。如果您有任何需求或疑问,欢迎随时与我们联系!

1.服务优势

2.联系方式

欢迎随时联系我们!我们将竭诚为您提供高效、专业的技术支持,量身定制解决方案,助您轻松应对技术挑战。

项目数据

Tipps:传统的机器学习算法对图像进行识别等研究工作时,只需要很少的图像数据就可以开展工作。而在使用卷积神经网络解决研究的书法风格检测问题的关键其一在于搭建合适的神经网络,其二更需要具备大量优质的训练数据集,在大量的有标签数据不断反复对模型进行训练下,神经网络才具备我们所需要的分类能力,达到理想的分类效果。因此有一个质量较好的图像数据集至关重要。

数据集介绍:

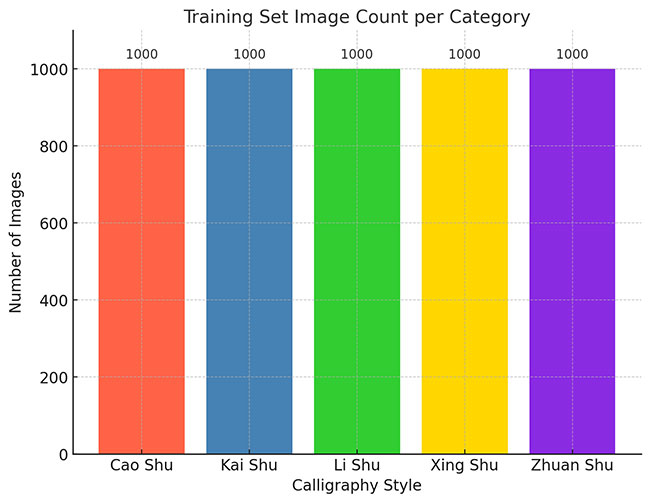

卷积神经网络的深度学习模型。数据集包含5000张图像,分布在5个类别中:”草书”,”楷书”,”隶书”,”行书”,”篆书”。数据集可用于训练和验证深度学习模型,以实现书法风格的自动化分类识别,同时可以结合数据增强技术(如翻转、裁剪、噪声添加等)优化模型性能,为书法风格研究提供重要支持。

数据集已被预先标注,每个类别的图像数量基本均衡,为训练和验证提供了稳定的基准。数据集被划分为训练集和测试集。

数据集划分

数据集已预先划分为两个部分:训练集和测试集,具体如下:

(1)训练集:”草书” 1000张图像,”楷书” 1000张图像,”隶书” 1000张图像,”行书” 1000张图像,”篆书” 1000张图像,共5000张图像。用于模型训练,通过最小化损失函数优化参数。

(2)测试集:”草书” 298张图像,”楷书” 297张图像,”隶书” 298张图像,”行书” 297张图像,”篆书” 298张图像,共1488张图像。用于评估模型在未见数据上的表现

这种数据集划分方式有助于保证模型训练和评估的可靠性,确保各数据集独立,避免数据泄露和过拟合。

实验超参数设置

本实验中的主要超参数设置如下:

(1)学习率:0.0001,使用Adam优化器,能够自适应调整学习率,表现较好。

(2)批次大小:训练时为32,验证时为64,较小的批次大小有助于稳定训练并提高计算效率。

(3)优化器:使用Adam优化器,适用于稀疏数据和非凸问题。

(4)损失函数:采用交叉熵损失函数(CrossEntropyLoss),适用于多分类任务。

(5)训练轮数:设定为15轮,帮助模型逐渐收敛。

(6)权重初始化:使用预训练的VGG16和ResNet50权重进行迁移学习,加速收敛并提高分类性能。

这些超参数设置经过反复调试,以确保模型在验证集上表现良好。

硬件环境

我们使用的是两种硬件平台配置进行系统调试和训练:

(1)外星人 Alienware M16笔记本电脑:

(2)惠普 HP暗影精灵10 台式机:

上面的硬件环境提供了足够的计算资源,能够支持大规模图像数据的训练和高效计算。GPU 的引入显著缩短了模型训练时间。

使用两种硬件平台进行调试和训练,能够更全面地验证系统的性能、适应性和稳定性。这种方法不仅提升了系统的鲁棒性和泛化能力,还能优化开发成本和效率,为实际应用场景的部署打下良好基础。

实验过程与结果分析

Tipps:分析VGG16和ResNet50两种模型在肺癌检测分类任务中的实验结果。包括训练过程中的损失与准确率变化、模型性能对比、混淆矩阵(热力图)分析、过拟合与欠拟合的讨论,以及计算效率的分析。

训练过程中的损失与准确率变化

为了评估模型在训练过程中的表现,我们记录了每个epoch的训练损失、训练准确率以及验证损失、验证准确率。通过这些指标,我们可以观察到模型是否能够有效收敛,以及是否存在过拟合或欠拟合的情况。

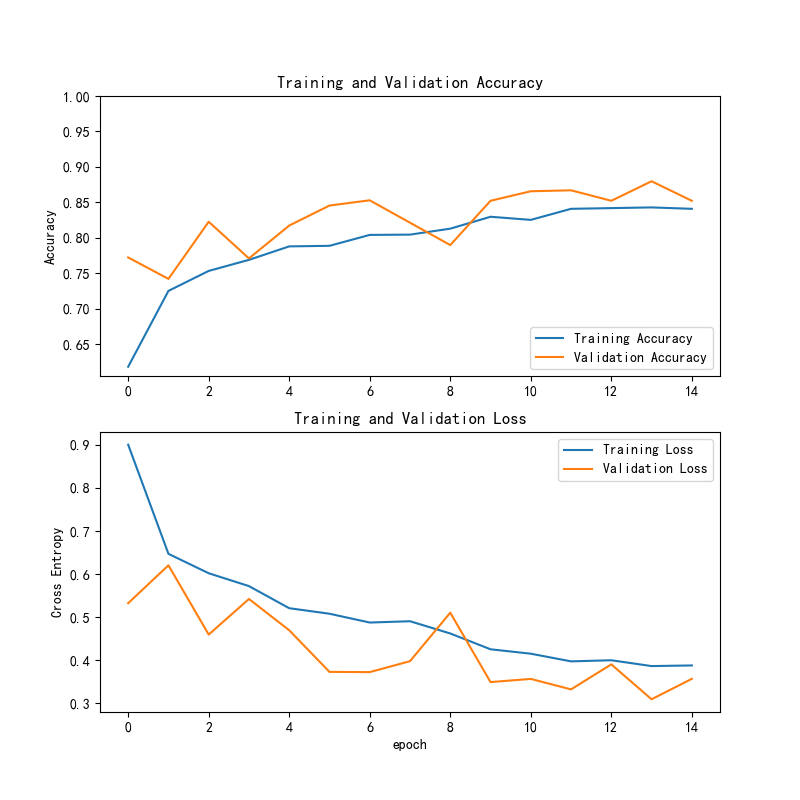

1.1 VGG16模型训练过程

VGG16模型在训练过程中的损失和准确率曲线如下所示:

训练精度与验证精度:

(1)训练精度(Training Accuracy)从大约0.65逐渐提高至接近0.90,显示出模型在训练集上的学习效果越来越好。

(2)验证精度(Validation Accuracy)随着epoch的进行有所波动,但总体上表现出缓慢的上升趋势,在最后达到约0.85。这表明模型在验证集上的性能相对稳定,但在某些epoch出现了波动,可能由于数据的复杂性或训练过程中的不稳定因素。

训练损失与验证损失:

(1)训练损失(Training Loss)在最初几epoch中较高,但逐渐降低,最终稳定在接近0.4。这表明模型正在逐步学习到更有效的特征,并且损失在减少。

(2)验证损失(Validation Loss)在大部分epoch中下降,最终趋于平稳,保持在0.4左右,尽管偶尔出现轻微的波动。与训练损失类似,验证损失的表现也是逐渐改善的。

总体趋势:

(1)训练精度和训练损失表现出稳步的优化趋势,训练精度上升,训练损失逐步下降。模型在训练集上的学习效果逐渐增强。

(2)验证精度和验证损失整体呈现出稳定向好的趋势,验证精度逐渐增加,而验证损失则逐步下降。虽然验证精度有所波动,但模型在验证集上的表现仍较为稳定。

总结:

模型在训练过程中表现出良好的学习能力,训练精度和验证精度稳步提升,损失逐渐下降,展示了较强的泛化能力。

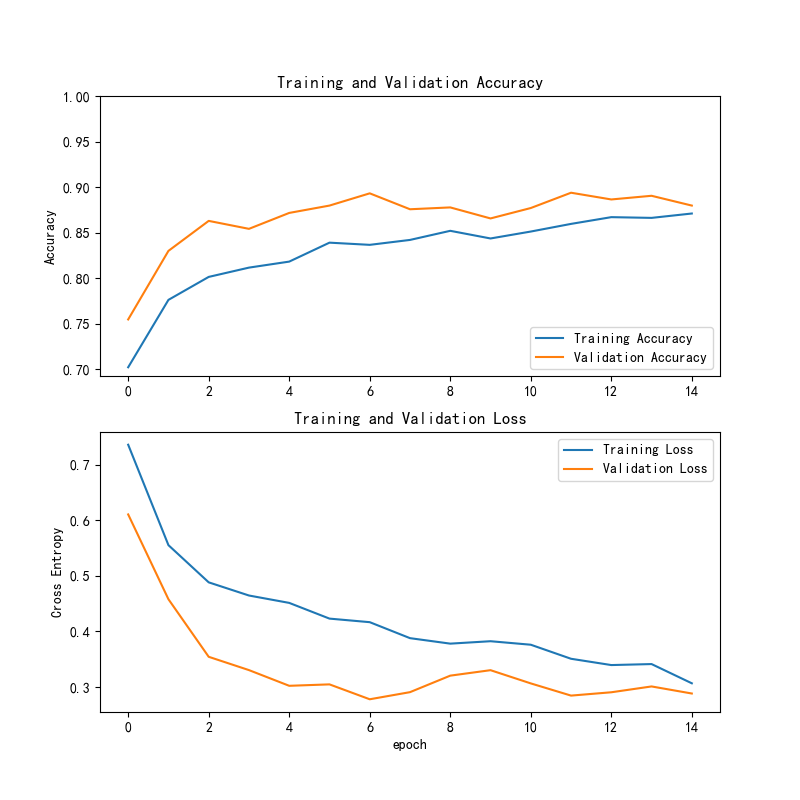

1.2 ResNet50模型训练过程

ResNet50模型在训练过程中的损失和准确率曲线如下所示:

训练精度与验证精度:

(1)训练精度(Training Accuracy)在前几个epoch中逐步提高,并且在后期趋于平稳,接近0.90。

(2)验证精度(Validation Accuracy)在前几个epoch中有一个较快的提升,之后也逐渐趋于平稳,最终达到了约0.88左右。验证精度虽然有所波动,但总体趋势与训练精度一致,显示出模型的有效学习能力。

训练损失与验证损失:

(1)训练损失(Training Loss)从较高的值(接近0.6)逐渐下降,并趋向稳定,最终保持在0.3到0.4之间。

(2)验证损失(Validation Loss)也在下降,且比训练损失的变化更加平滑。它的下降趋势更为平稳,接近训练损失的表现。

总体趋势:

(1)训练精度和训练损失表现出了稳定的优化趋势,训练精度逐步提升,损失逐步降低。

(2)验证精度和验证损失虽然在某些epoch有所波动,但整体上验证精度也在上升,验证损失在持续下降。这表明模型在验证集上有着较好的表现,且未出现过拟合。

总结:

训练过程没有显著的过拟合现象,损失下降与精度提升的趋势健康,可以进一步优化超参数以提高模型的性能。

从损失和准确率的曲线来看,ResNet50在训练过程中的收敛速度和稳定性都优于VGG16,表明其更适合处理复杂的分类任务。

模型性能对比

训练精度和验证精度

(1)ResNet50:该模型在训练集和验证集上的表现通常较为稳定,训练精度逐步上升,验证精度也在一定范围内提高,收敛后趋于平稳。ResNet50通常在较复杂的任务中能够提取更多的特征,表现出更高的验证精度。

(2)VGG16:VGG16在训练集上的精度也逐步提高,但由于其较深的网络结构和参数数量,容易出现较大范围的波动,尤其是在验证集上的精度波动较大,可能导致过拟合现象的发生。尽管如此,VGG16也能够逐步提高验证精度,但通常收敛较慢。

训练损失与验证损失

(1)ResNet50:ResNet50的训练损失和验证损失通常都呈现出稳步下降的趋势。由于其残差连接的设计,能够较好地避免梯度消失问题,从而在较深层的网络中依然能保持较低的损失,具有较强的稳定性。

(2)VGG16:VGG16的训练损失和验证损失虽然逐渐降低,但由于其网络较深,训练过程中可能会出现较为明显的波动,尤其在深层网络的训练时,损失减少的速度可能较慢。此外,VGG16较容易受到过拟合的影响,导致验证损失较高。

模型收敛速度

(1)ResNet50:ResNet50因其设计上的优势(如残差连接),具有较快的收敛速度。在较少的epoch内,模型通常能达到较高的训练精度和较低的训练损失,收敛过程比VGG16更为迅速且稳定。

(2)VGG16:VGG16相对而言,收敛速度较慢,尤其是在复杂的任务中。由于其较深的层数和参数量,训练和验证过程可能会经历较多的波动,最终达到较稳定的收敛状态通常需要更多的epoch。

计算性能

(1)ResNet50 的计算量较大,但得益于其残差连接和GPU加速,其训练效率较高。

(2)VGG16 虽然结构简单,但计算量较大,训练速度较慢,特别是在较长周期时,计算效率稍逊。

综合评估

(1)ResNet50 在深度网络的优化方面表现优秀,训练速度快且泛化能力强,适合复杂任务。

(2)VGG16 在训练精度上表现良好,适合计算资源较少的环境,但泛化能力相对较弱。

总结:

如果目标是高准确率且拥有足够的计算资源,推荐使用 ResNet50;如果计算资源有限或任务较为简单,可以选择 VGG16。

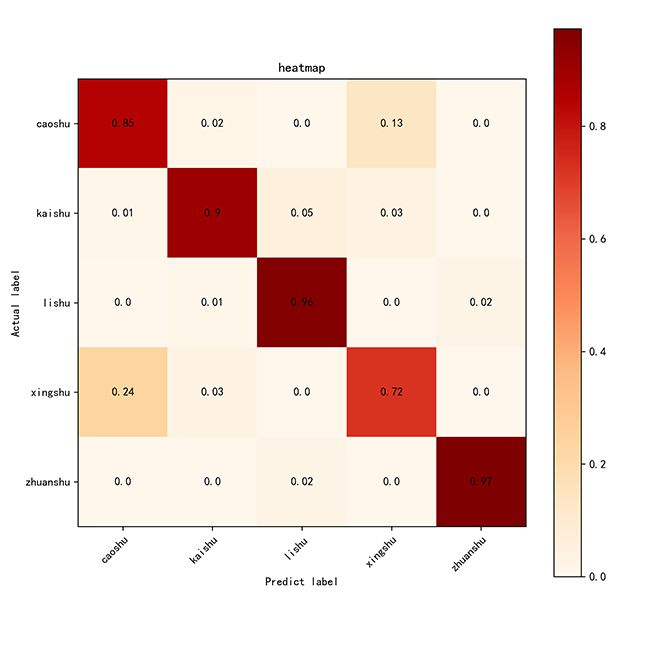

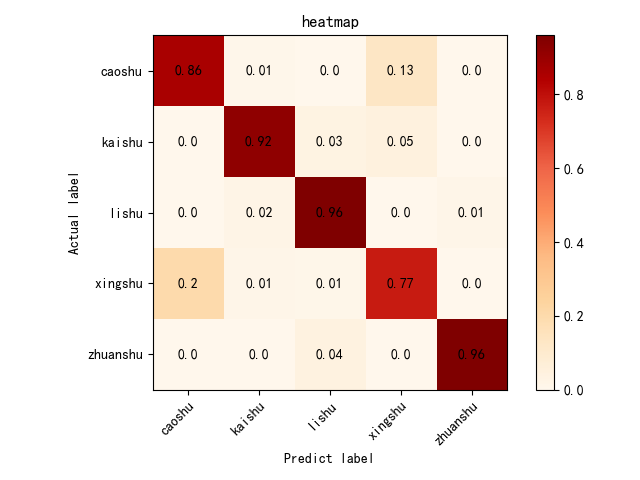

混淆矩阵分析(热力图)

为了更全面地分析模型的分类性能,我们生成了混淆矩阵并将其可视化为热力图,帮助我们直观地了解模型在哪些类别上表现较好,在哪些类别上存在误分类。

1.VGG16的热力图:

(1)优点:准确率高:大部分类别的准确率都较高,特别是 隶书(lishu) 和 篆书(zhuanshu),准确率接近0.96和0.97,显示出模型对这些类别的识别能力很强。

(2)改进方向:减少误分类:尽管大多数类别表现良好, 草书(caoshu) 和 行书(xingshu) 之间存在较大的误分类,建议通过增加数据量或数据增强技术进一步改进这两类的区分能力。

2.ResNet50的热力图:

(1)优点:准确率高:大部分类别的准确率较高,特别是 隶书(lishu) 和 篆书(zhuanshu),表现非常好,准确率接近0.96。

(2)改进方向:虽然模型表现良好,但 草书(caoshu) 和 行书(xingshu) 之间存在一些误分类,可以通过增强数据集或使用更多的类别特征来进一步优化。

计算效率分析

(1)ResNet50通常在计算效率、训练时间、推理速度和内存使用方面优于VGG16。尽管其网络较深,但由于残差连接的存在,训练时的梯度消失问题得到缓解,使得ResNet50能更快地收敛并达到较好的性能。

(2)VGG16由于其庞大的参数量和较浅的结构,在训练时需要更多的计算资源和内存,同时推理速度也较慢。对于一些硬件受限的环境,VGG16可能不如ResNet50高效。

如果计算效率是项目的关键考虑因素,ResNet50 更适合用于大规模训练任务,尤其是在时间有限的情况下。

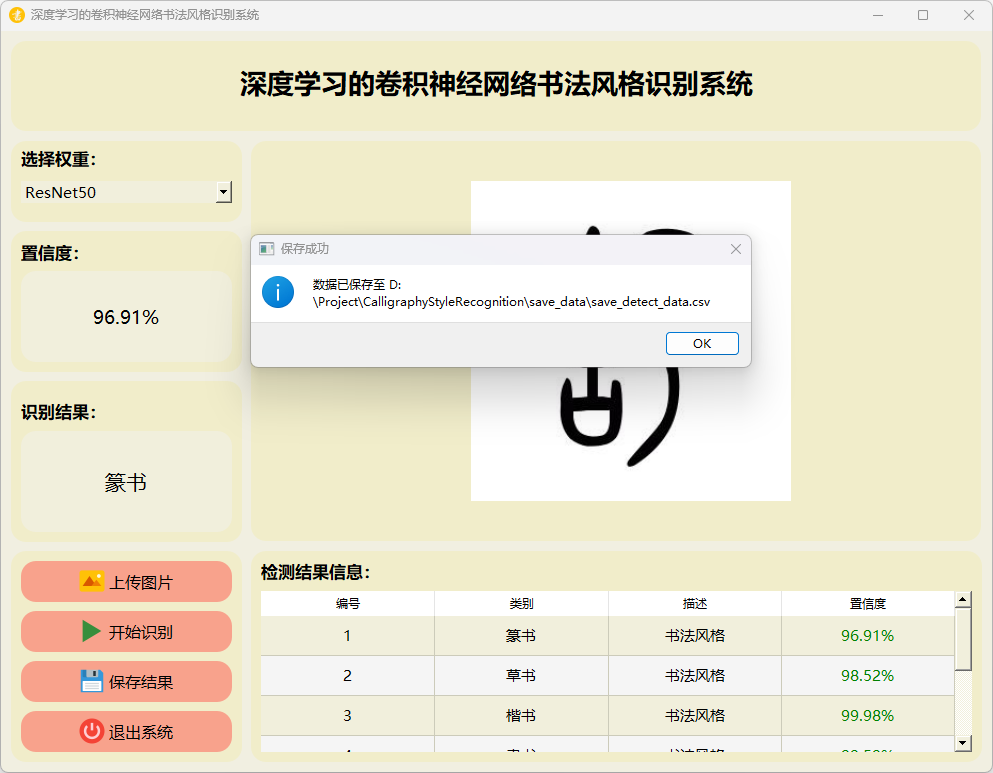

运行效果

– 运行 MainProgram.py

1.ResNet50模型运行:

(1)主界面

(2)草书

(3)楷书

(4)隶书

(5)行书

(6)篆书

2.VGG16模型运行:

(1)主界面

(2)草书

(3)楷书

(4)隶书

(5)行书

(6)篆书

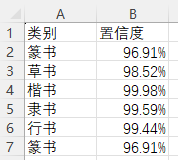

3.检测结果保存

点击保存按钮后,会将当前选择的图检测结果进行保存。

检测的结果会存储在save_data目录下。

图片文件保存的csv文件内容如下:

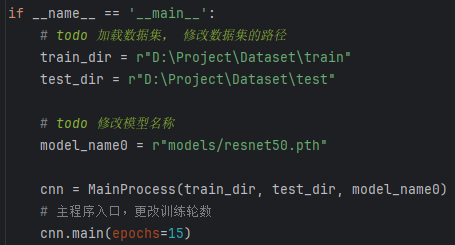

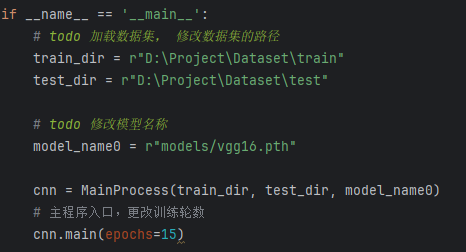

– 运行 train_resnet50.py

这段代码的主要目的是在直接运行该脚本时,加载指定路径下的训练集和测试集,初始化一个 MainProcess 实例并训练模型(ResNet50),设置训练的轮数为 15 轮。

数据集路径设置:

(1)train_dir = r”D:\Dataset\train”:设置训练集数据的路径。

(2)test_dir = r”D:\Dataset\test”:设置测试集数据的路径。

模型路径设置:

(1)model_name0 = r”models/resnet50.pth”:指定训练模型的文件路径,这里是 resnet50.pth 模型的路径,用于加载预训练的 ResNet50 权重或保存训练后的模型。

实例化MainProcess类:

(1)cnn = MainProcess(train_dir, test_dir, model_name0):通过传入训练集路径、测试集路径和模型路径,创建 MainProcess 类的实例 cnn,这个类负责数据加载、模型训练、验证等操作。

调用主函数main进行训练:

(1)cnn.main(epochs=15):调用 cnn 对象的 main 方法,开始训练模型。epochs=15 表示模型训练将进行50轮(每轮遍历整个训练集一次)。该方法将包括模型的训练过程、损失计算、验证等步骤

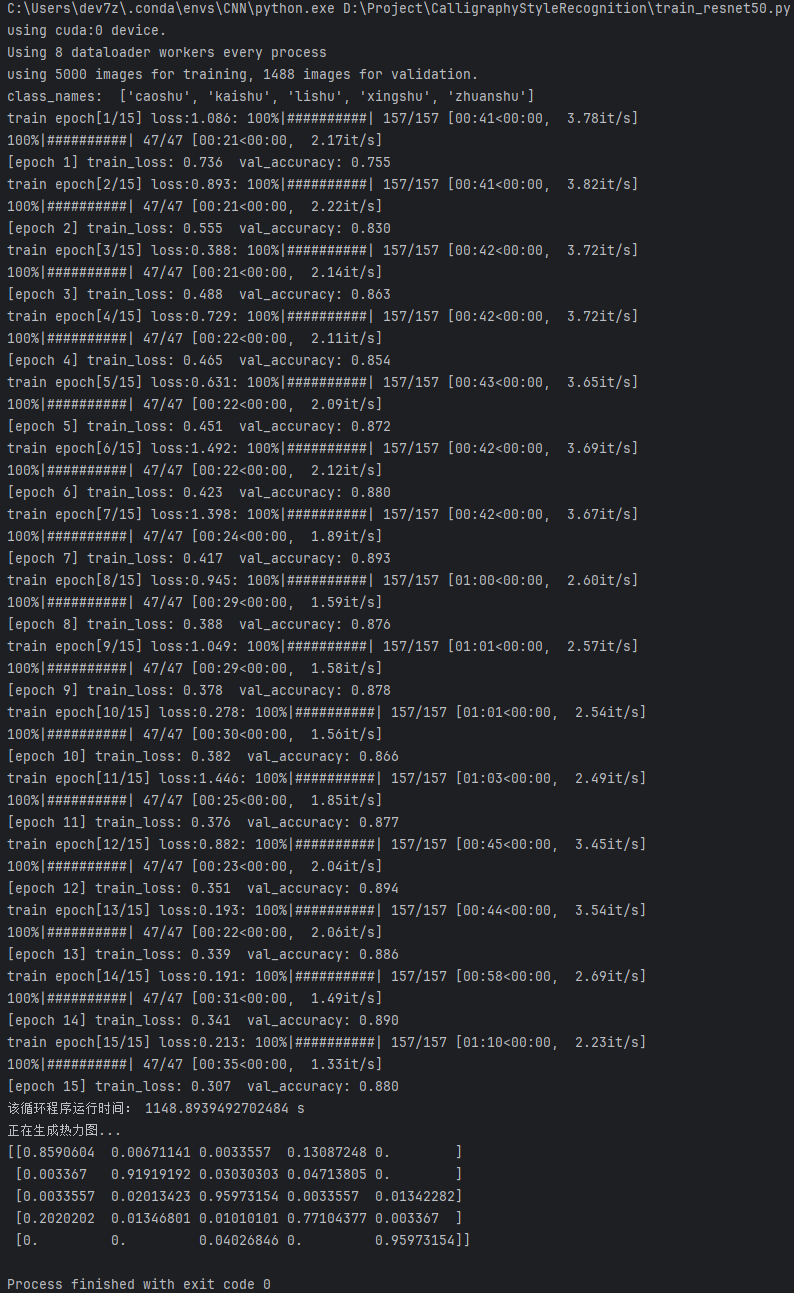

训练日志结果

ResNet50日志结果

这张图展示了使用ResNet50进行模型训练的详细过程和结果。

配置信息:

(1)模型在训练了15轮后,总共耗时19分钟。

(2)本次训练使用了GPU设备,具体是CUDA设备0。

训练损失:

(1)训练损失(train_loss)从第1个epoch的1.086逐步下降至第15个epoch的0.213。

(2)损失的逐步下降表明模型在不断优化,其学习过程表现较好。

验证准确率:

(1)验证准确率(val_accuracy)从第1个epoch的0.755提高到第15个epoch的0.880,说明模型在验证集上的表现不断改善,并逐渐达到较好的准确度。

训练速度:

(1)训练速度(训练每个epoch的迭代速度)在日志中显示,每秒处理的批次数(如“3.78it/s”,“2.09it/s”等)随着训练的进行而有所波动。

(2)整体来看,训练速度在合理范围内,但随着训练的深入可能会略有下降,特别是在较复杂的epoch。

模型表现:

(1)验证准确率在15个epoch的训练后达到了0.880,这表明模型有着良好的表现,能够较为准确地分类书法风格。

(2)训练损失逐渐降低,而验证准确率持续提升,模型逐步学习到了有效的特征,并且没有出现明显的过拟合问题。

完成信息:

(1)Process finished with exit code 0:表示整个验证过程顺利完成,没有报错。

总结:

(1)模型的训练过程表现稳定,损失逐步降低,验证准确率稳步上升,表明模型在处理书法风格识别任务时具有较好的学习能力。

(2)训练过程没有出现过拟合,损失下降与验证准确率的提升相符合,且训练速度稳定在可接受范围内。

(3)可以进一步通过调整超参数或引入正则化来进一步优化模型。

– 运行 train_vgg16.py

这段代码的主要目的是在直接运行该脚本时,加载指定路径下的训练集和测试集,初始化一个 MainProcess 实例并训练模型(VGG16),设置训练的轮数为 15 轮。

数据集路径设置:

(1)train_dir = r”D:\Dataset\train”:设置训练集数据的路径。

(2)test_dir = r”D:\Dataset\test”:设置测试集数据的路径。

模型路径设置:

(1)model_name0 = r”models/vgg16.pth”:指定训练模型的文件路径,这里是 vgg16.pth 模型的路径,用于加载预训练的 VGG16 权重或保存训练后的模型。

实例化 MainProcess 类:

(1)cnn = MainProcess(train_dir, test_dir, model_name0):通过传入训练集路径、测试集路径和模型路径,创建 MainProcess 类的实例 cnn,这个类负责数据加载、模型训练、验证等操作。

调用主函数main进行训练:

(1)cnn.main(epochs=15):调用 cnn 对象的 main 方法,开始训练模型。epochs=15 表示模型训练将进行50轮(每轮遍历整个训练集一次)。该方法将包括模型的训练过程、损失计算、验证等步骤

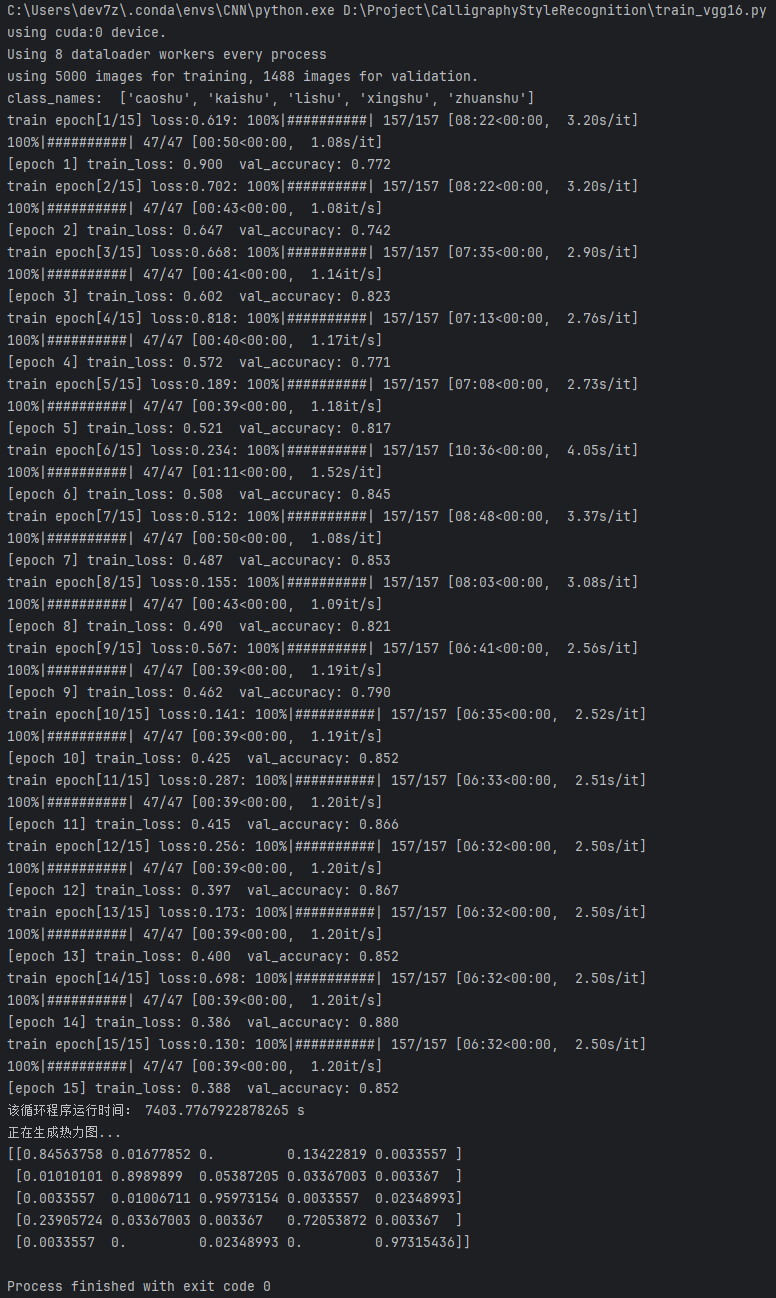

训练日志结果

VGG16日志结果

这张图展示了使用VGG16进行模型训练的详细过程和结果。

配置信息:

(1)模型在训练了15轮后,总共耗时 2小时。

(2)本次训练使用了GPU设备,具体是CUDA设备0。

训练损失:

(1)训练损失(train_loss)从第1个epoch的0.619逐步降低到第15个epoch的0.388。

(2)这表明模型在训练过程中逐渐优化,学习到有效的特征。

验证准确率:

(1)验证准确率(val_accuracy)从第1个epoch的0.772提高至第15个epoch的0.852。

(2)这表明模型在验证集上的表现逐步改善,能够较好地泛化到未见过的数据。

训练速度:

(1)训练速度(训练每个epoch的迭代速度)显示了模型每秒处理的批次数(如“1.08it/s”,“1.18it/s”等)。

(2)这个速度在不同的epoch中有所波动,通常在训练初期较快,后期可能由于模型训练的复杂性略微下降。

模型表现:

(1)模型的验证准确率最终达到了0.852,显示了较好的识别性能。这表明模型能够有效区分不同的书法风格,且泛化能力较强。

(2)训练损失逐渐下降,验证准确率逐步提高,表明模型没有出现严重的过拟合,且在训练集和验证集上均有良好表现。

完成信息:

(1)Process finished with exit code 0:表示整个验证过程顺利完成,没有报错。

总结:

(1)模型在训练过程中表现出持续的优化,损失逐步减少,验证准确率持续上升,训练速度在大多数时间里保持稳定。

(2)训练达到较好的效果,模型能够较为准确地识别书法风格,但仍有进一步提升的空间。可以考虑进一步优化网络结构或增加正则化手段来提升模型的准确度和鲁棒性。

远程部署

Tipps:购买后可有偿协助安装,确保运行成功。

– 远程工具:Todesk 、向日葵远程控制软件

– 操作系统:Windows OS

– 客服QQ:3666308803

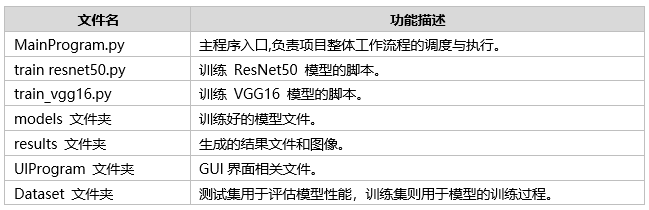

项目文件

文件目录

Tipps:完整项目文件清单如下:

通过这些完整的项目文件,不仅可以直观了解项目的运行效果,还能轻松复现,全面展现项目的专业性与实用价值!

评论(0)